1. 다운로드

링크 : spark.apache.org/downloads

Downloads | Apache Spark

Download Apache Spark™ Choose a Spark release: Choose a package type: Download Spark: Verify this release using the and project release KEYS. Note that, Spark 2.x is pre-built with Scala 2.11 except version 2.4.2, which is pre-built with Scala 2.12. Spar

spark.apache.org

2. 압축풀기

저는 Documents 아래에 압축을 풀었습니다.

$ pwd

~/Documents/spark-3.1.1-bin-hadoop2.73. SPARK_HOME 설정

.zshrc에 SPARK_HOME을 아래와 같이 설정합니다.

$ vi ~/.zshrc

export SPARK_HOME=/Users/dvwy/Documents/spark-3.1.1-bin-hadoop2.7/bin4. 테스트 수행

$ cd ~/Documents/spark-3.1.1-bin-hadoop2.7

$ bin/spark-submit --class org.apache.spark.examples.SparkPi \

--master local examples/jars/spark-examples_2.12-3.1.1.jar 10

반응형

'빅데이터 > 하둡' 카테고리의 다른 글

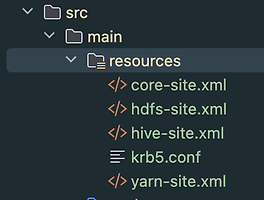

| Spark 개발시, main/resources 패키지에 hdfs-site.xml, core-site.xml 등을 넣는 이유 (0) | 2024.08.13 |

|---|---|

| 하둡 맵리듀스 동작방법 (0) | 2020.11.26 |

| 하둡 맵리듀스 접근법 (0) | 2020.11.24 |

| HDFS cilent 사용시 HA구성된 node 연결하기 (0) | 2020.03.11 |

| pyspark에서 gzip으로 압축되어 있는 파일 읽는 방법 (0) | 2020.02.11 |

| pyspark에러 ImportError: No module named XXXX (1) | 2020.02.10 |